Veranstaltungsrückblick NEON-Plenum „Tools zur Digitalisierung des Forschungsprozesses“ am 1. März 2023, online

Worum ging es beim NEON-Plenum am 1. März?

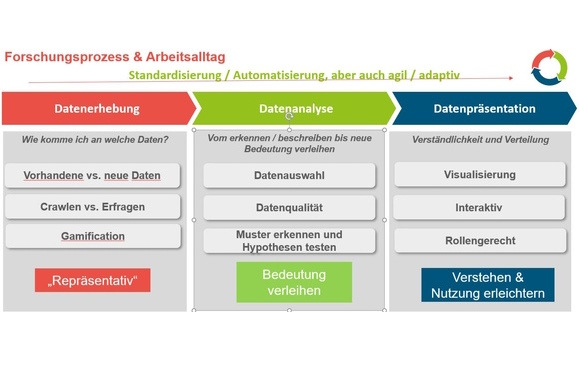

Fast alle Schritte des Forschungsprozesses lassen sich digitalisieren, egal ob es sich um Erhebung, Analyse oder Ergebnisdarstellung handelt (s. Graphik).

Standardisierung & Automatisierung haben auch für unsere Branche eine große Bedeutung. Digitalisierung bedeutet aber auch, Forschern Testpersonen und Kunden agilere, interaktivere und intuitivere Instrumente an die Hand zu geben.

Wie können Nicht-Teilnehmer Verpasstes nachholen oder auch Teilnehmer Kennengelerntes vertiefen?

Session 1: Nutzer wirksam beschreiben – Customer Journey visualisieren, Effekte trennen und kompakt analysieren

- Alexander Skorka stellte DisplayR als Tool vor, mit dem man sich interaktiv/explorativ einen Datensatz erschließen kann.

Außerdem stellten vor:

- Natalie Schmidt von Ipsos, wie auch qualitative Projekte wie ethnographische Ansätze von digitalen Tools profitieren können,

- Dr. Robert Orlowski von Psyma die Kombination aus Normalisierung von Daten in einem DataLake sowie der interaktive und visuelle Ergebniszugriff darauf,

- Laura Schulze von DataLion die Vision eines Autopiloten für die Marktforschung – wie man eine Vielzahl von Reports automatisiert erstellt.

Session 2: (Agiles) Konzept-Testing & DIY

- Markus Edgar Hormeß führte das Publikum durch vielfältige Möglichkeiten, mit OpenAI und anderen KI-Tools Prototyping für Texte, Konzepte, Anzeigen, Videos, Apps betreiben zu können.

Außerdem zeigten uns:

- Chris Schachinger von INNOFACT, wie man ein Chipgame ausbaut, um nicht nur Gamification für Testpersonen zu ermöglichen, sondern auch Absatz & Kannibalisierung abschätzen kann,

- Dr. Ella Jurowskaja von EARSandEYES, wie man sich mit Kvest selbst einen Pretest zusammenstellen und/oder Kosten & Aufwand abschätzen kann.

In beiden Fällen zeigte sich, dass sowohl bewährte Standards wie auch Anpassung an Kundenbedürfnisse trotz Standardisierung & Automatisierung wichtig sind.

Session 3: Datenquellen & Compliance

- Zum Abschluss zeigte uns Michael Stanko von Stanko & Partner, dass es zwar vielfältige Möglichkeiten für OpenData – auch dank entsprechender gesetzlicher Grundlagen von Bund und Ländern – gibt, etwa im Bereich Wetter, Tourismus & Geodaten. Gerade für die Erstellung eigener Anwendungen ist jedoch eine verlässliche Bereitstellung und Qualitätskontrolle dieser Daten wichtig.

- Thomas Altenbach von LegalTegrity führte uns durch deren digitales Hinweisgebersystem: Wie man eine digitale Anwendung nutzen kann, um anonymes Feedback & Hinweise einfach einholen, verwalten und damit die kommende gesetzliche Verpflichtung erfüllen kann.

Dr. Frank Knapp

BVM-Vorstandsvorsitzender/

Fachgruppe NEON im BVM